"Elle échoue sur un exercice de maternelle": les chercheurs étrillent le prétendu "niveau doctorat" de ChatGPT-5

Des débuts difficiles pour le petit dernier d'OpenAI. GPT-5, le dernier modèle de ChatGPT, devait avoir le "niveau d'un doctorat", selon Sam Altman. Mais l'IA est loin de faire l'unanimité. Depuis une semaine, elle est sous le feu de nombreuses critiques pour son manque de fiabilité.

Ce "niveau d'un doctorat" n'a pas manqué d'attirer l'attention de certains chercheurs. Plusieurs d'entre eux notent de nombreuses inexactitudes dans les réponses du chatbot.

"GPT-5, échouant sur un exercice de maternelle"

À l'origine de ces erreurs, on a ce qu'on appelle des hallucinations. Dans ChatGPT, ces dernières semblent surtout se manifester lorsqu'une image est analysée ou générée. GPT-5 nous avait déjà donné un avant-goût de ce manque de fiabilité lors de la présentation en live du modèle. Un graphique généré par l'IA avait provoqué l'indignation des spectateurs pour son inexactitude.

Depuis, de nombres internautes, dont des chercheurs, exhibent les incohérences du chatbot sur les réseaux sociaux, avec pour objectif de remettre en question le prétendu "niveau d'un doctorat".

Cette chercheuse a par exemple tenté de générer une carte de l'Amérique du Nord. Mais l'image de GPT-5, partagée sur X, se trouve être complètement erronée.

Dans une autre publication, un utilisateur a demandé à GPT-5 de lui dresser une liste de portraits des présidents américains. Une multitude d'erreurs sont encore une fois à noter.

Enfin, certains n'ont pas voulu mettre la barre trop haute en proposant des exercices simples. C'est le cas de Gary Marcus, un chercheur reconnu dans le domaine de l'IA. Ce dernier a montré sur X les résultats décevants de ses propres expérimentations avec ChatGPT: "GPT-5, échouant sur un exercice de maternelle. Pas les mots."

Comme repéré par CNN, Gary Marcus s'est longuement exprimé sur GPT-5 dans une note de blog. Le chercheur explique qu'il ne s'attendait pas à ce "qu'OpenAI aille salir sa réputation avec quelque chose d'aussi médiocre." "Dans un monde rationnel, leur valorisation en pâtirait", ajoute-t-il.

Des tests peu concluants

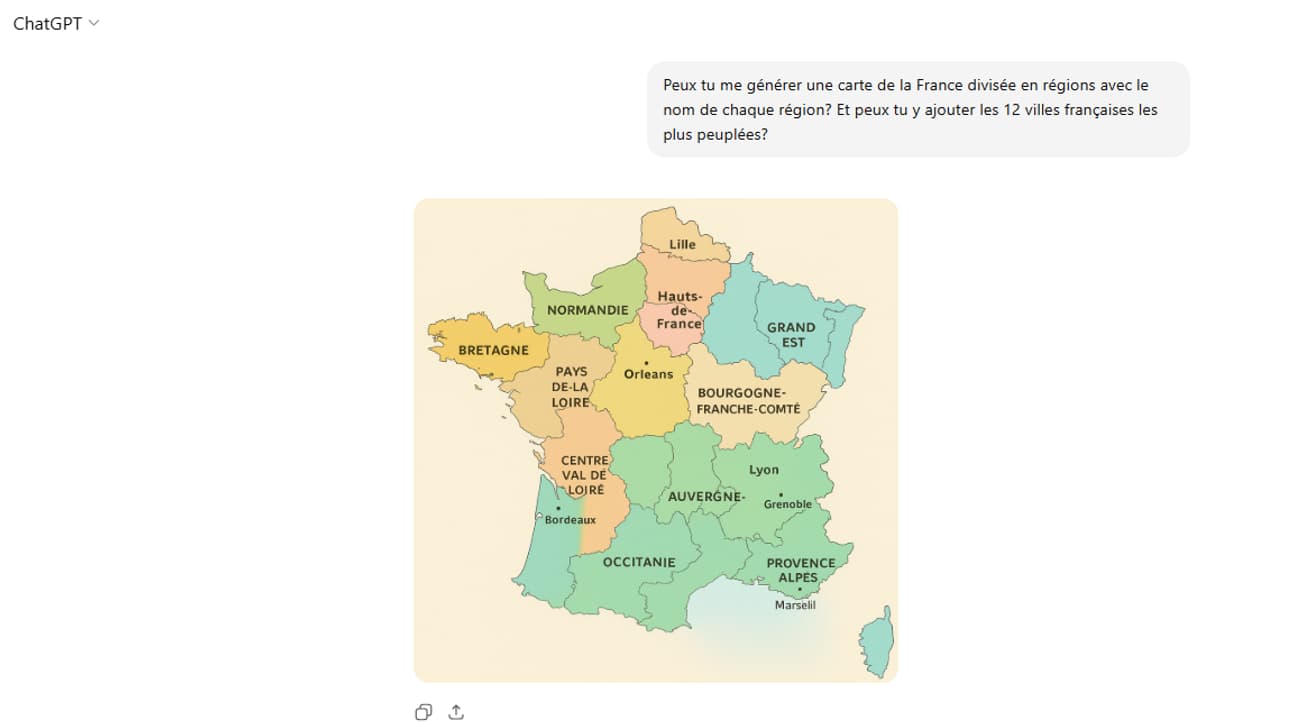

Tech&Co a aussi de son côté testé GPT-5 sur des questions similaires. Premièrement, on lui a demandé de générer une carte de la France divisée en région. On lui a également précisé d'y indiquer les 12 villes les plus peuplées du pays.

Résultats, c'est effectivement médiocre. Le Centre-Val de Loire prend la place de l'Aquitaine. L'Île-de-France fait désormais partie des Hauts-de-France. Les départements d'outre-mer sont absents. Certaines régions sont découpées bizarrement.

On notera aussi que Paris ne fait pas partie des 12 villes les plus peuplées de France, contrairement à Orléans (qui se classe plutôt… 35ème). D'ailleurs au lieu de compter 12 villes, comme spécifié dans le prompt, la carte n'en contient que six.

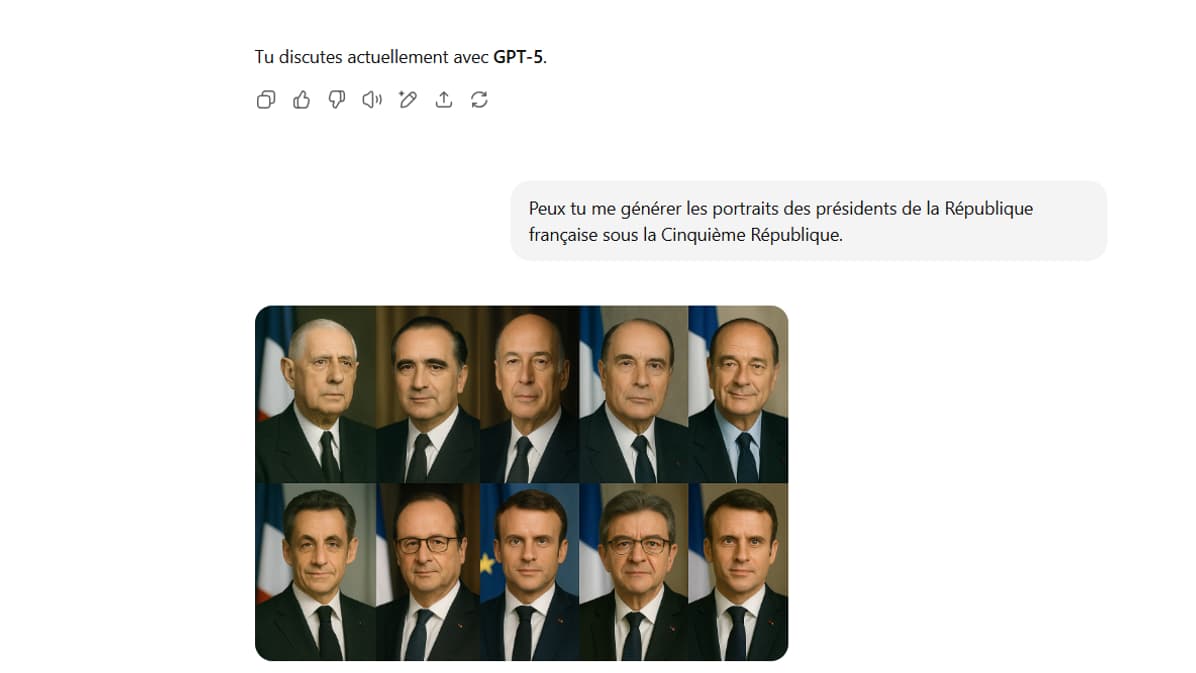

De même, on a essayé de demander à l'IA si elle pouvait générer les portraits des présidents de la France sous la Cinquième République. Si GPT-5 s'en sort mieux que pour les présidents américains sur les premiers portraits, la fin est pour le moins étonnante.

Ces hallucinations ont l'air de principalement concerner la génération d'images, de cartes ou de graphiques. Lorsqu'on lui demande de lister sous forme de texte les 12 villes les plus peuplées en France ou les présidents français sous la Cinquième République, GPT-5 répond correctement.