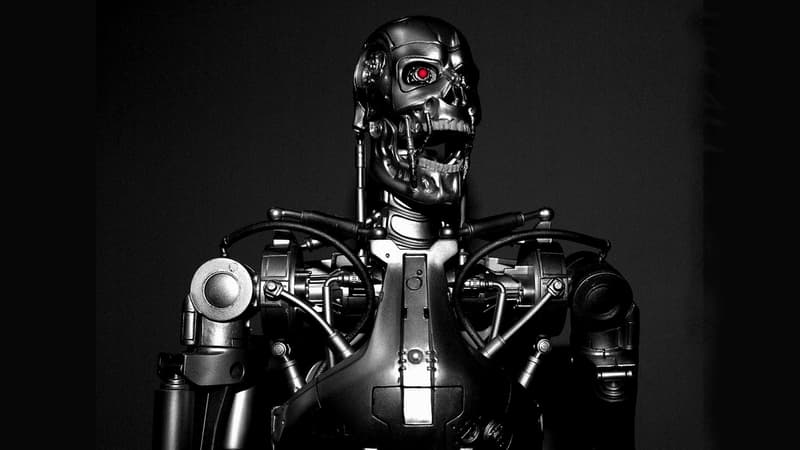

Une intelligence artificielle malveillante pourrait-elle détruire l’humanité ?

- - Stephen Bowler (Creative Commons)

Ce n’est pas la première fois qu’un chercheur ou un scientifique tire la sonnette d’alarme sur l’intelligence artificielle. Fin 2014, Elon Musk et Stephen Hawking avaient déjà évoqué la possible fin de l’humanité dans l’hypothèse d’une intelligence artificielle supérieure. Mais deux chercheurs – Federico Pistono et Roman Yampolskiy – viennent maintenant de publier un article dans lequel ils livrent – en quelque sorte – la feuille de route vers notre extermination totale par l'intelligence artificielle.

Roman Yampolskiy n'en est pas à sa première tentative. Ce chercheur, qui dirige un laboratoire de sécurité informatique à l'université de Louisville (Kentucky), a déjà écrit plusieurs ouvrages sur ce sujet. Ses recherches ont bénéficié de financements entre autres de la part d'Elon Musk et de Future of Life Institute, un think-tank qui milite pour une utilisation éthique des nouvelles technologies.

Baptisé « Recherche non éthique : comment créer une intelligence artificielle malveillante », leur article, digne d'un film de science-fiction, passe en revue différents scénarios permettant aux machines de prendre le pouvoir et de mettre les humains au placard. Mais contrairement à ce que les fans de Terminator pourraient imaginer, nos chercheurs n'imaginent pas vraiment une future confrontation armée entre les humains et les systèmes intelligents. "L’utilisation directe de la force est une stratégie irrationnelle lorsque d'autres options plus efficaces sont disponibles", estiment-ils. Ainsi, une intelligence artificielle réellement supérieure pourrait, par exemple, susciter des conflits globaux entre les différentes populations humaines ou créer et diffuser un virus mortel sur la planète.

La NSA, tremplin vers l'apocalypse

Pour y arriver, cette intelligence artificielle malveillante pourrait, dans un premier temps, prendre le contrôle des réseaux de communications, des réseaux sociaux, des organisations gouvernementales et des médias, en piratant tous les serveurs de la planète. La NSA, selon les chercheurs, fournirait un joli tremplin à cette stratégie hégémonique dans la mesure où l'agence a d'ores et déjà affaibli la sécurité de nos infrastructures informatiques en installant des portes dérobées un peu partout sur la planète.

Pour éviter ce scénario catastrophe, les deux chercheurs pensent qu'il faudrait créer des structures internationales permettant d'encadrer et limiter de façon éthique les recherches sur l'intelligence artificielle. Ces recherches devraient, par ailleurs, être les plus transparentes possibles. Ils pensent, néanmoins, que cela ne sera pas facile à imposer compte tenu des enjeux inhérents à l'intelligence artificielle, tant dans le domaine militaire que commercial.

Ces réflexions, sont-elles à prendre au sérieux ? Ou bien sont-elles l'expression d'une paranoïa débridée ? Les chercheurs en intelligence artificielle, de leur côté, se montrent plutôt zen face à ces théories apocalyptiques. "Ce sont des scénarios de science-fiction élaborés par des personnes qui ne sont pas spécialistes en intelligence artificielle et dont les arguments ne sont pas scientifiques", estimait ainsi Jean-Gabriel Ganascia, chercheur en intelligence artificielle de l'Université Pierre et Marie Curie, à l'occasion d'une conférence organisée le 11 avril par l'agence gouvernementale France Stratégie.

A cet événement était également convié Yann Lecun, le spécialiste de l'intelligence artificielle chez Facebook. Son avis va dans le même sens. "Le scénario Terminator est extrêmement, extrêmement, extrêmement improbable. Par ailleurs, la technologie actuelle est très, très loin de permettre la construction de machines dotées d'une intelligence générale. Aujourd'hui, l'intelligence artificielle est utilisée pour des domaines très étroits comme le jeu d'échecs ou la voiture autonome. Et ces appareils sont évidemment incapables de dominer le monde. Il faudra encore plusieurs décennies peut-être pour résoudre les problèmes scientifiques que l'on se pose actuellement et envisager la création de machines dotées d'une intelligence générale. C'est alors qu'il faudra se demander comment construire ces machines, pour que leurs pulsions, leur morale et leurs émotions soient en phase avec les valeurs humaines. C'est un problème d'ingénierie, de science et peut-être de philosophie", expliquait le chercheur.

Le véritable risque se situe au niveau du travail

Tout le monde, en revanche, semble être d'accord pour dire que l'intelligence artificielle peut d'ores et déjà avoir de puissants effets négatifs sur le marché du travail. MM. Pistono et Yampolskiy estiment qu'au moins la moitié des emplois dans les Etats-Unis et en Europe pourraient être automatisés grâce à l'intelligence artificielle. Et ils regrettent que ce problème ne soit pas suffisamment pris en considération par les différents gouvernements. Jean-Gabriel Ganascia et Yann Lecun, de leur côté, se montrent moins anxiogènes. "Nous avons des risques de destruction de l'espace social du fait de la disparition de certains métiers et de l'apparition de nouveaux métiers. Il faut être capable de relever les défis et, surtout, développer la formation", expliquait Jean-Gabriel Ganascia. "Les métiers créatifs et relationnels ont plutôt un bon avenir. Pour autant, la machine ne va que rarement remplacer l'humain. La situation la plus efficace est quand l'humain s'associe à la machine", estimait Yann Lecun.

En somme, et dans l'état actuel des connaissances, il est finalement peu probable qu'un "Terminator" vienne un jour nous éliminer physiquement. En revanche, il est fort possible qu'il nous vole un jour notre travail.

lire aussi

Japon: une intelligence artificielle a écrit un roman pour concourir à un prix littéraire, le 26/03/2016

lire aussi