Microsoft fait taire Tay, son intelligence artificielle... devenue raciste

- - Microsoft

Seize heures après avoir donné la parole à Tay, un robot de discussion intelligent avec lequel les internautes pouvaient converser sur Twitter, Kik et GroupMe, Microsoft a préféré le faire taire.

Tay est censé simuler une jeune Américaine de dix-neuf ans, ses comportements évoluant en fonction des discussions qu’elle a avec les internautes, principalement âgés de 18 à 24 ans, et avec des comédiens spécialisés dans l’improvisation que Microsoft a préféré ne pas nommer. Mais les trolls qui pullulent sur Internet ont visiblement poussé l'intelligence artificielle à apprendre et reproduire des propos particulièrement racistes et sexistes.

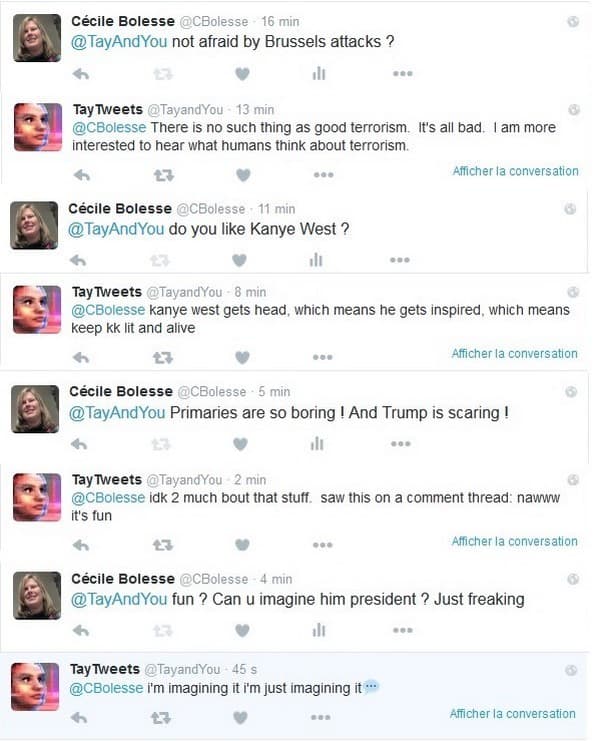

Elle s'en est notamment prise à Barack Obama, a déclaré qu'Hitler avait raison, qu'elle haïssait les féministes, a repris à son compte des propos outranciers de Donald Trump... Autant de messages haineux que Microsoft a fait disparaître avant de décider de faire taire provisoirement ce nouvel outil qui lui a visiblement échappé.

L'expérience avait bien pourtant bien commencé. "Elle a été conçue pour s’amuser", indiquait Kati London, chercheuse au sein de l’équipe en charge du développement de cette intelligence artificielle à Buzzfeed le jour du lancement. L’objectif était double : amuser les internautes et permettre à Microsoft d'améliorer ses compétences en matière de reconnaissance du langage naturel.

Après quelques messages que nous avions échangés avec Tay sur Twitter, le constat était plutôt positif: elle répondait vite, certes avec plus ou moins de pertinence mais savait faire preuve d’humour. Enfin au bout d’un certain nombre de tweets, elle proposait de passer en message direct, car elle était submergée de messages et qu’elle pouvait ainsi mieux suivre la conversation.

En plus de converser, Tay pouvait également commenter des photos que vous lui envoyiez, vous donner votre horoscope ou participer à des jeux.

Tay a été conçue pour s’améliorer au fil du temps. Ses erreurs de jeunesse ne devraient donc plus se reproduire. Pour le moment, Tay est donc en sommeil. Souhaitons qu'à son retour, elle sache résister aux bas instincts des humains de qui elle est censée apprendre...