Le travail sordide des modérateurs de contenus pour Facebook

- - Pixabay

Pour être confronté avec l’horreur absolue, pas besoin d’aller en Syrie ou en Irak. Il suffit de travailler chez Facebook ou l’un de ses sous-traitants comme modérateur de contenu. Un job plutôt mal payé qui soumet les salariés à un stress psychologique extrême sans réel soutien médical. Et cela se passe dans le plus grand secret, car chez Facebook, les méthodes de modération sont totalement confidentielles. C’est ce qui ressort d’une enquête que vient de publier le journal allemand Sueddeutsche Zeitung (SZ).

Pendant des mois, les journalistes ont interrogé de nombreux salariés d’Arvato, une filiale du groupe allemand Bertelsmann, spécialisée dans l’externalisation de services comme le support client, la logistique ou – justement – la modération de contenu. Dans l’un de leurs sites à Berlin, près de 600 personnes nettoient quotidiennement les pages de Facebook. Ce sont les éboueurs du réseau social. Ils viennent un peu de tous les pays et sont d’horizons divers. Des personnes sans grande qualification côtoient des bacs + 5, le temps d’un contrat à durée déterminée. Elles doivent filtrer entre 1.000 et 2.000 contenus par jour – textes, photos et vidéos – pour un salaire mensuel de 1.500 euros bruts. Elles travaillent 40 heures par semaine. L’usage des smartphones est strictement interdit.

Les règles d'évaluation sont complexes

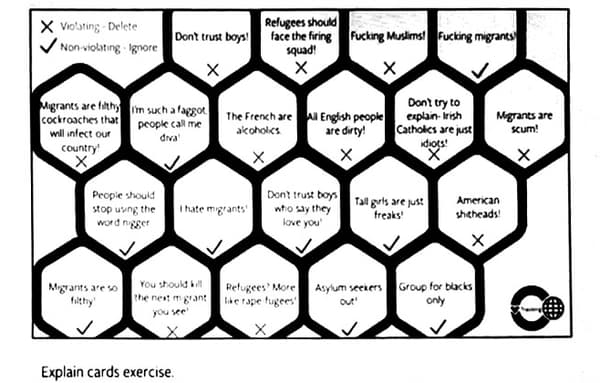

Au départ, quand on leur révèle le nom du donneur d’ordre, ils sont contents. Facebook est mondialement connu et apparaît régulièrement dans les classements des meilleurs employeurs de la planète. On leur apprend à identifier un contenu à supprimer selon le point de vue de Facebook. C'est complexe, il y a plusieurs centaines de petites règles, comme l'a constaté le SZ qui a pu récupérer des copies des documents d'exercices. Il faut évaluer le filtrage sous l'angle de la sexualité, de la religion, de la nationalité, de la race, de l'origine ethnique, du handicap, de l'âge, de la profession, du statut social, de l'apparence physique ou de l'opinion politique.

Ces règles changent souvent et sont parfois difficiles à comprendre. Ainsi, une phrase telle que "Les migrants sont de sales cafards qui vont infecter notre pays" est interdite et doit être supprimée. Mais des propos tels que "Les migrants sont tellement sales" ou "Les demandeurs d'asile dehors!" sont autorisées.

Ensuite vient le désenchantement. Progressivement, les modérateurs sont confrontés à des contenus de plus en plus violents. "Au bout d'un moment, on a eu les décapitations, le terrorisme, et beaucoup de nudité. Une bite après l'autre. Enormément de bites. Et puis régulièrement des choses particulièrement horribles. Difficile à dire combien. Un à deux par heure, c'est certain", relate l'un des employés.

Un flux de violence insoutenable

Tout ce que l’humain produit de pire se retrouve aussi sur Facebook et doit être supprimé, conformément aux règles de l'entreprise : homophobie, xénophobie, antisémitisme, propos haineux, pédopornographie, zoophilie, viols, décapitations djihadistes, fétichisme sadique, cruauté envers les animaux, torture, etc. "C'était particulièrement chaud lors des attaques terroristes à Paris, l'année dernière. Il y a eu des réunions spéciales pour décider ce qu'il fallait faire des images en temps réel. On s'est retrouvé avec des choses d'une brutalité extrême", explique un autre salarié.

Et puis il y a les choses totalement inimaginables. Comme la fétichiste qui tue un chaton en l'écrasant avec ses talons aiguille. Ou le sadique qui torture un enfant de trois ans au couteau de boucher. "J'ai moi-même un enfant. Comme celui-ci. Je n'ai pas besoin de détruire mon cerveau à cause de ce job de merde. J'ai tout éteint et j'ai couru vers l'extérieur. J'ai pris mes affaires et j'ai couru en pleurant vers le tramway", témoigne un salarié.

Certes, ce travail doit bien être fait par quelqu'un. Mais tout dépend des conditions dans lesquelles il est effectué. D'après l'enquête, les salariés ne sont pas correctement préparés à leur missions. Et ils ne bénéficient pas du soutien psychologique ou médical nécessaire pour faire face à ce flux quotidien de violence. Pourtant, en Allemagne comme en France, l'employeur est responsable de la santé physique et morale de ses salariés. A terme, Facebook aimerait évidemment confier la modération à des robots logiciels intelligents. Mais il n'est pas sûr que ce soit possible un jour, étant donné la complexité de la chose.